Nvidia 能維持它的高估值嗎?(上)

蓬勃發展的資料中心業務

本期重點

中國市場風險上升,股價面臨挑戰

客戶名單透露出來的重要訊息

資料中心業務

中國業務下滑的風險

遊戲、視覺專業化與汽車業務

Nvidia 的估值合理嗎?

中國市場風險上升,股價面臨挑戰

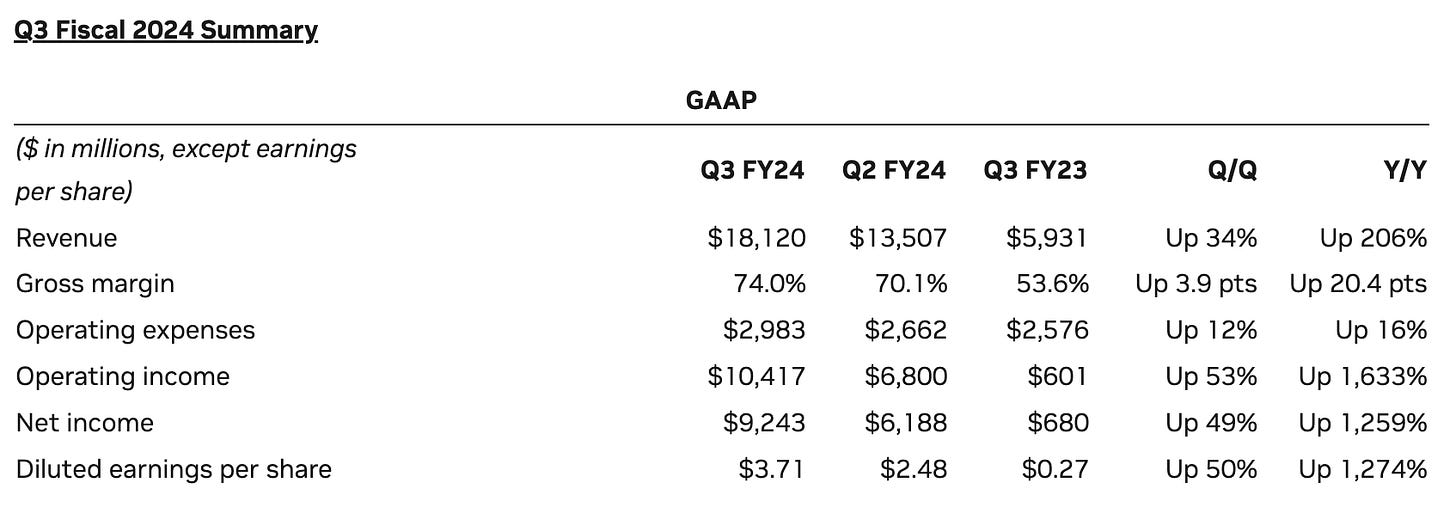

AI 的浪潮方興未艾,Nvidia 2023 年第三財季(8~10月)收入為 181.2 億美元,較去年同期增長 206 %,較上季增長 34 %,超過分析師預估的 161 億美元。第三季每股盈餘(EPS)3.71美元,較去年同期增長 12倍,也較上季增加 49 %(表一)。

表一 第三季度業績表現(除 EPS 外,百萬美元)

公司創辦人兼首席執行官黃仁勳(Jenson Huang)在業績說明會上表示,第三季業績強勁增長的原因主要來自幾點:

公司強勁的增長反映了產業廣泛地從通用計算(general-purpose computing)過渡到加速計算(accelerated computing)與生成式人工智慧(generative AI)的趨勢 正在進行。

大型語言模型初創公司(large language model startups) 、消費者互聯網企業(consumer Internet companies) 與全球性雲端服務提供業者(global cloud service provider) 成為這次產業變革的先行者。

國家和區域性雲服務提供商正在投資人工智慧以滿足當地的需求,企業軟體公司正在為其平台增加人工智慧副駕駛與人工智慧助手(AI copilot and assistants) ,企業本身也正在量身打造適合自身的人工智慧,以最大程度的實現行業的自動化。

Nvidia 的 GPU、CPU、網路產品與AI 代工服務(AI foundry service) 成為公司收入全速增長的引擎,生成式人工智慧的年代正在起飛。

Nvidia 公佈了大型公司難得一見的業績與獲利的高成長,但公司財務長 Colette Kress在業績發表會上也同時表示:

在臨近第三季末的時候,美國政府宣佈了一系列針對中國和其他包括越南和某些中東國家新的出口管制措施。這些法規要求 Nvidia 的一些產品的銷售需要出口許可證,其中包括 Hopper 和 Ampere 100 和 800 系列以及其他的一些產品。

在過去的幾個季度里,Nvidia 對中國和其他受影響市場的銷售,來自於受出口許可要求的部分,一直貢獻著大約 20% 到 25% 的資料中心收入。

Nvidia 預計對這些目的地的銷售額將在第四季度大幅下降。

在 11 月 21 日公佈第三季業績的當天,Nvidia 的股價還短暫創下 505.48 美元的新高,但在接下來的交易日,股價開始走低。

Nvidia 目前面臨中國等市場營收下降的風險,公司有能力克服挑戰,重拾業務增長的動能嗎?Nvidia 能持續支持它的高估值嗎?在這一期的文章中,我們試圖回答這些問題。

客戶端透露出來的重要訊息

在過去,Nvidia 一直被認為是一家販賣遊戲顯卡與提供挖礦算力的公司。直到 OpenAI 在去年 11 月發布 ChatGPT,並在短短 2 個月的時間成為內擁有超過一億用戶的應用程式,讓世界看到了人工智慧廣泛運用的可能,人工智慧的 iPhone 時刻才翩然而至。

目前,從 Nvidia 在第三季業績報告中隱含的客戶範圍中,我們看到這一次推動人工智慧浪潮的力量首先來自於全球頂尖的重量級客戶,包括全球性的雲端服務供應商與消費性互聯網企業如電子商務與社交媒體如微軟、谷歌、亞馬遜、Meta 等。

由於這些公司本身已經面向廣大的企業用戶與消費者群體,使得人工智慧的普及將有別於當初的互聯網,需要克服光纖網路的舖設、電信技術的發展、消費性電子產品的普及,以及一般消費者對互聯網程式應用的熟悉、信任與接受等漫長的過程。

在行業基礎設施相對完善,銷售通路相對暢通下,人工智慧縮短了面向大眾的時間,不但提升了行業與個人的競爭力,擴大了增加收入的機會,也降低了產生泡沫的風險。

同時,不僅僅是全球性的雲端服務供應商,人工智慧的浪潮正在往下滲透。區域性的雲端服務供應商、以軟體為服務的公司(Software-as-a-Service,SaaS)如 Salesforce、以及大型企業如 Tesla 也在採購 Nvidia 人工智慧解決方案的行列。除了滿足當地與自身的需求外,更像是進入一場沒有跟上就要落後、甚至被淘汰的競賽。甚至以國家為主體的人工智慧發展中心如英國,也參與發展人工智慧的行列,以國家擁有的大量資料,提升國家的競爭力,延續自己的文化。對於 Nvidia 來說,客戶的範圍推廣到了國家的層面。

資料中心業務(Data Center)

在目前人工智慧發展的初期階段,硬體設施的建設和投資從資料中心開始。受惠於加速運算與生成式人工智慧的發展,Nvidia 的資料中心業務呈現爆發性的成長,華爾街也聚焦其中。

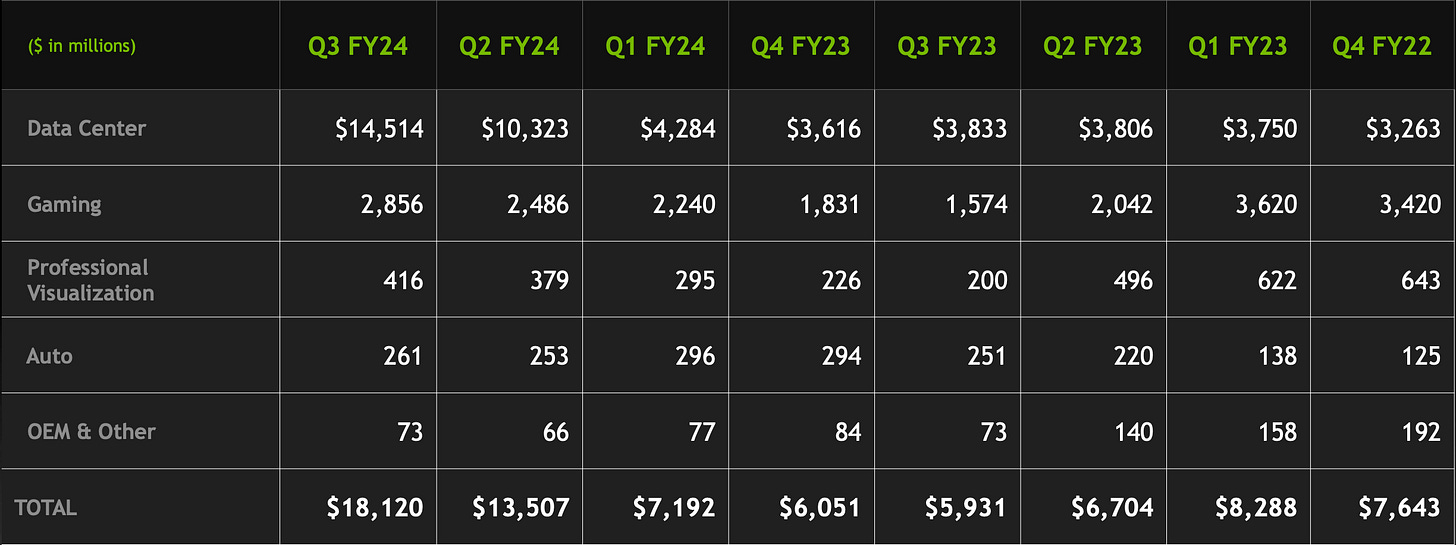

在 Hopper Tensor Core GPU 架構下 Nvidia HGX 平台以及 InfiniBand 端到端網絡(end-to-end networking)的推動下,Nvidia 資料中心業務在 2023 年第三財季創下 145.1 億美元收入的新紀錄,較上季成長 41%,更較去年同期增長 279 %。資料中心業務佔 Nvidia 整體收入的比重已經超過 80%,預計趨勢還在持續中(表二)

表二 第三財季表現(市場別)

Nvidia HGX 加上 InfiniBand 本質上已經成為人工智慧超級電腦和資料中心基礎設施的參考架構。

目前一些最令人興奮的生成式人工智慧應用程式包括 Adobe Firefly, ChatGPT, Microsoft 365 Copilot, CoAssist,以及 ServiceNow 和 Zoom AI Companion,都是在 Nvidia 上構建與運行。

Nvidia 資料中心計算解決方案的收入是去年的四倍,而網絡收入幾乎是去年的三倍。

在訓練和推理大型語言模型(Large Language Model)、深度學習、推薦系統和生成式人工智能應用等基礎設施方面的投資,推動了對 Nvidia 加速計算產品廣泛而強勁的需求。

在客戶方面,消費者互聯網公司和大型企業在第三季度推動了 Nvidia 驚人的增長,約佔 Nvidia 資料中心收入的一半,超過了整體增長。

Meta 等公司正在全面開發深度學習、推薦系統,並投資於生成式人工智慧,以幫助廣告商優化圖像和文本。大多數主要的消費互聯網公司也都在加快生成式人工智慧的部署。

企業採用人工智慧的浪潮也正在開始。Adobe、Databricks、Snowflake 和 ServiceNow 等企業軟體公司正在將人工智慧副駕駛和輔助系統添加到公司的平台上。

更多的企業正在為自身所處的行業開發專屬的人工智慧應用,比如特斯拉在自動駕駛的領域。

雲端服務提供商(Cloud Service Provider,CSP)約佔資料中心收入的另外一半。

所有超大規模的雲服務提供商包括 Amazon,Microsoft,Google 都是 Nvidia的客戶,並正與 Nvidia 進行進一步深度的合作。

為了應對人工智能領域新的市場機遇,越來越多的專用 GPU (GPU-specialized)雲服務提供商對 Nvidia 產品和解決方案的需求強勁,這些雲服務提供商本身的業務也正在迅速的增長。

許多國家也開始意識到,需要投資自主的人工智能基礎設施,以支持經濟持續的增長和產業的創新。通過對於計算能力的投資,各國可以使用自己的數據來訓練大型語言模型,並支持本地的生成式人工智慧生態系統。

例如,Nvidia 正在與印度政府和包括印 Infosys、Reliance 和 Tata 在內的大型科技公司合作,以提升他們主權人工智慧的基礎設施。

法國私有雲提供商 Scaleway 正在構建一個基於 Nvidia H100 InfiniBand 和Nvidia AI Enterprise 軟體的區域人工智慧雲,以推動法國和歐洲的發展。

對於國家來說,計算能力的投資成為新的經濟要務。對於 Nvidia來說,主權人工智慧基礎設施的建置,代表著未來幾年數十億美元的市場機會。

從產品的角度來看,第三季度的絕大部分收入是由基於 Hopper GPU 架構的Nvidia HGX 平台所驅動,上一代 Ampere GPU 架構的貢獻較小。

Nvidia 為標準伺服器構建的新型 L40S GPU 已經開始發佈,支持跨各種消費者的訓練和推理工作負載。

GH200 Grace Hopper 超級晶片結合了基於 ARM 的 Grace CPU 和 Hopper GPU 也在第三季度開始了收入。Grace Hopper 已經在 GPU 專用雲提供商使用,並且很快就會進入Oracle Cloud。

Grace Hopper 在超級電腦客戶中也獲得了巨大的吸引力。Los Alamos 國家實驗室和瑞士國家超級計算中心在第三季度進行了首批發貨。英國政府宣佈將建造世界上最快的人工智能超級電腦之一,名為 Isambard-AI,配備近 5,500 顆 Grace Hopper 超級晶片。

德國超級計算中心 Julich 也宣佈,將使用近 2.4 萬個 Grace Hopper 超級晶片和Quantum-2 InfiniBand 構建世界上最強大的下一代人工智慧超級電腦,擁有超過每秒 90 百億億次(exaflops)的人工智慧運算性能 。

Nvidia 內部估計明年美國、歐洲和日本所有在 Grace Hopper上建造的超級計算機的人工智能計算能力將超過 200 exaflops。

Grace Hopper 正在發展成一條價值數十億美元的新產品線。

Nvidia 同時在第三季公佈了採用新型 Nvidia H200 Tensor Core GPU 的 HGX™ H200,這是首款採用 HBM3e 記憶體的 GPU。在推理速度上,H200

在 GPT-3 上比 H100 快1.6倍,在 Llama 上比 H100 快 1.9 倍。

除了可以負載超過 1,750 億個參數的大型語言模型的訓練和推理外,H200 也將在邊緣計算(edge computing)和物聯網(Internet of Tings,IoT)的人工智慧應用中發揮關鍵作用。

H200 預計將於明年第二季度上市。